Série “Focus IA générative” - Partie 1

L’IA générative est un sujet majeur depuis octobre 2022 et la sortie de ChatGPT 3.5 en octobre 2022. Chez Dydu, en tant qu’expert de l’IA conversationnelle depuis 2009, nous avons suivi l’évolution de l’IA générative avec attention. Au cours de nos différents échanges avec nos clients, nos partenaires, nos prospects, nous avons constaté que le sujet reste relativement complexe à appréhender. Par ailleurs, l’écosystème évolue très rapidement, ce qui rend la tâche encore plus difficile. Cette série d’articles “Focus IA générative” a pour but de rappeler les fondamentaux sur les LLMs, de déconstruire certaines idées reçues et de donner des éléments de réflexion à son utilisation.

Qu’est-ce qu’un LLM ?

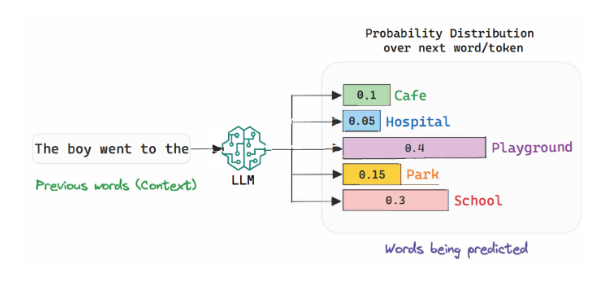

Les LLMs (Large Language Models) sont des modèles d’apprentissage automatique capables de comprendre et de générer des textes en langage humain. Ils fonctionnent en analysant d’énormes ensembles de données textuelles pour apprendre à prédire les mots qui viendront ensuite dans une phrase. Ils vont ensuite générer des réponses cohérentes en se basant sur ces probabilités. Un LLM propose systématiquement le “token” le plus probable selon son contexte, ce contexte s’enrichissant à chaque nouveau token ajouté. Cet ajout est appelé “inférence” dont nous verrons le processus plus bas.

Ces modèles utilisent des réseaux de neurones pour détecter les relations entre les mots et les phrases, ce qui leur permet de produire des textes cohérents et pertinents. Vous pouvez imaginer un LLM comme un assistant de rédaction ultra-intelligent, qui s’appuie sur des données accumulées issues de livres, articles et forums en ligne, pour fournir des réponses pertinentes et bien construites.

Comment fonctionne un LLM ?

À travers un processus appelé « inférence« , le modèle analyse les séquences de mots et utilise des probabilités pour prédire la suite. Il enrichit continuellement le contexte à chaque mot ou phrase ajouté, améliorant ainsi la précision de ses réponses.

Prenons un exemple simple. Si vous donnez au modèle le début d’une phrase comme :

👉 « Le soleil se lève à l’est et… ». Le LLM va s’appuyer sur ses vastes connaissances pour prédire des complétions plausibles comme « se couche à l’ouest ».

Il est donc important de fournir au prompt d’entrée (contexte initial) un maximum d’informations pertinentes, c’est le prompt engineering.

Source : The Philosophical Ledger

Les 6 étapes clés de l’apprentissage d’un LLM

1 – Récolte, nettoyage et fractionnement des données : La première étape de la formation d’un LLM consiste à récolter des données textuelles provenant de diverses sources, comme des livres, articles de presse, forums en ligne, etc. Une fois ces données collectées, elles sont nettoyées pour éliminer les erreurs, le contenu inapproprié et les biais. Enfin, les données sont découpées en petites unités (appelées tokens) que le modèle va analyser.

Par exemple, GPT-3.5 a été formé avec 570 Go de texte. Cela représente des millions de phrases, analysées pour comprendre la structure et les relations entre les mots.

2 – Configuration initiale du modèle (architecture transformée) : Une fois les données prêtes, le modèle est configuré. Il repose sur une architecture spécifique appelée transformer, conçue pour traiter de grandes quantités d’informations textuelles rapidement et efficacement. À cette étape, on définit également la taille du modèle, le nombre de couches de traitement et d’autres paramètres techniques.

3 – Entraînement du modèle : C’est l’étape la plus longue et la plus coûteuse. Le LLM est entraîné à prédire le prochain mot dans une phrase en fonction des mots précédents. L’objectif est de minimiser les erreurs au fil du temps. Ce processus est appelé apprentissage supervisé : le modèle apprend à partir d’exemples corrects qui lui sont donnés.

Idée reçue #1

Contrairement à ce que l’on pourrait croire, un LLM comme ChatGPT n’apprend pas des questions posées par les utilisateurs. Une fois le modèle formé, il est figé, sauf si on le réentraîne avec de nouvelles données.

4 – Vérification du modèle : Une fois l’entraînement terminé, le modèle est testé. On lui présente de nouvelles données qu’il n’a jamais vues pour vérifier sa capacité à généraliser et à fournir des réponses correctes. On utilise des mesures de performance pour s’assurer que le modèle fonctionne bien avant de le mettre à disposition des utilisateurs.

5 – Utilisation du modèle : Une fois validé, le modèle peut être déployé dans différentes applications. Par exemple, il peut être utilisé dans des chatbots, pour générer du contenu, ou encore pour fournir des réponses à des questions. Le modèle ne s’améliore pas à ce stade : il utilise simplement ce qu’il a appris lors de son entraînement initial.

6 – Amélioration du modèle : Si nécessaire, le modèle peut être réentraîné ou ajusté. C’est ce qu’on appelle le fine-tuning. Cela permet d’affiner ses réponses dans des contextes spécifiques ou d’ajouter de nouvelles données. Mais une fois déployé, il n’apprend pas automatiquement des interactions quotidiennes avec les utilisateurs.

Quelques notions importantes pour bien comprendre les LLM !

Hallucinations : L’une de leurs principales limitations est le phénomène des “hallucinations”, où le modèle produit des réponses incorrectes ou trompeuses, mais de manière très convaincante. Ces erreurs peuvent être problématiques, notamment dans des contextes professionnels où la précision est cruciale.

Idée reçue #2

Les hallucinations peuvent être évitées, mais la réalité c’est qu’elles sont inévitables en raison de leur architecture basée sur des probabilités, l’absence de compréhension profonde et les limites des données d’entraînement.

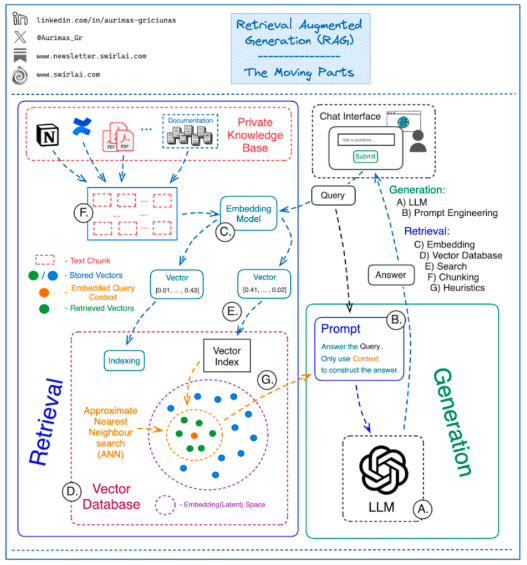

Retrieval Augmented Generation (RAG) Indexation sémantique : On parle ici de contenu textuel issu d’une base documentaire qui est indexé, puis “requêté” par une question utilisateur. Ceci permet la création d’un prompt donnant du contexte au LLM issu des documents ainsi que la question de l’utilisateur.

Fine tuning : Il s’agit du réentraînement d’un LLM déjà entraîné avec des informations de contexte complémentaires pour spécifier certaines réponses.

Source : SuperAnnotate

Optimiser les performances d’une l’IA générative

Les performances d’un LLM peuvent être ajustées grâce à plusieurs paramètres :

- La température : La température est une valeur ajustable entre 0 et 1 qui permet de gérer le degré de créativité du modèle. Plus la température est élevée (proche de 1), plus les réponses seront variées et créatives.

- Le Max New Tokens : Ce paramètre contrôle la longueur maximale des réponses générées.

- Le Top P et Top K : Ces valeurs influencent la diversité des mots sélectionnés par le modèle pour former une réponse, assurant un équilibre entre qualité et variété.

- Context window : pour générer une réponse, un LLM a besoin de contexte. La fenêtre de contexte est la taille maximale de ce contexte. Plus elle est grande, plus la réponse est de qualité, mais plus le temps de génération est long.

Pour conclure, cette introduction à l’IA générative offre un aperçu clair de son potentiel et de son fonctionnement. Mais ce n’est qu’un début. Dans les prochaines parties, nous explorerons les usages actuels et les défis de l’IA générative, en particulier les limites des LLMs et leur rôle dans nos outils numériques. Enfin, nous analyserons le marché des LLMs et leur avenir dans un secteur technologique en pleine évolution. Une suite à ne pas manquer pour anticiper les évolutions à venir !

👉 Restez connecté pour la suite de la série “Focus IA Générative” :

- Partie 2 : Usages et défis de l’IA générative

- Partie 3 : Quel avenir pour les LLMs ?

(Veille et restitution de Mathieu Changeat)